Известный аналитик о том, превзойдет ли искусственный интеллект человека и убьет ли его

«Автономные системы смертоносного оружия используют искусственный интеллект для идентификации и уничтожения человеческих целей без вмешательства человека. Их летальные версии называют «роботами-убийцами». Автономное оружие, управляемое искусственным интеллектом, а не людьми, будет становиться все более точным, быстрым и смертоносным», — говорит ведущий аналитик Института системно-стратегического анализа Елена Ларина. В интервью «БИЗНЕС Online» она дала полную характеристику настоящему и будущему искусственного интеллекта, его перспективам и опасностям, рассказала об удивительных способностях нейросетей, человекообразных роботах с ИИ, а также о том, грозит ли нам вытеснение машинами и вымирание.

«Можно определить ИИ как сочетание сверхмощных компьютеров с нейронными сетями и глубоким машинным обучением»

— Елена Сергеевна, сейчас очень много разговоров об искусственном интеллекте, причем зачастую этот термин употребляют не всегда к месту (особенно наши чиновники), нередко даже не зная, что это такое. «Интеллект» в переводе с латинского означает в том числе «понимание» и «рассудок». Если мы говорим об искусственном интеллекте, то подразумеваем, что машина нас понимает так же, как человек, и у нее есть рассудок? А если нет, то, может быть, уместно применить к этим машинным вариациям другой термин, а не «интеллект»? Почему именно «интеллект»?

— Вы совершенно правы. Сегодня об искусственном интеллекте не говорит и не пишет только ленивый. И действительно, зачастую люди употребляют термин, не представляя, что это такое. Слишком много существует на эту тему домыслов и преувеличений. Основная причина споров об искусственном интеллекте — в понимании самого термина.

Как говорят китайцы, самое важное в деле — дать ему правильное имя. Искусственному интеллекту в этом плане не повезло. Термин неудачный. Однако менять его уже поздно. Он стал общеупотребительным не только среди публики, но и среди специалистов и практиков. Проблема в том, что никто не знает, что такое интеллект или сознание. Поэтому дополнение эпитета «искусственный» лишь запутывает понимание термина «интеллект». Кроме того, мы пока не можем охарактеризовать, какие виды вычислительных процедур хотим назвать интеллектуальными. Мы понимаем одни механизмы интеллекта и не понимаем другие.

На протяжении долгих лет сложилось множество мифов о сути искусственного интеллекта. Сегодняшний бум искусственного интеллекта создает у многих иллюзию, что мы имеем дело с каким-то новейшим открытием. Это не так. Знаменитый компьютерщик Джон Маккарти написал статью «Что такое искусственный интеллект» около 60 лет назад. В ней он привел следующее определение: «Искусственный интеллект — это то, что помогает достигать заданных целей».

Еще в 40-е годы XX века такие ученые, как Норберт Винер (основоположник кибернетики), Джон фон Нейман (основоположник теории игр), Конрад Цузе (разработчик первого компьютера), академик Андрей Колмогоров (создал оригинальную теорию информации, отличную от Винера), писали, что искусственный интеллект возможен. Американский исследователь Марвин Мински в те годы дал определение искусственного интеллекта. ИИ — это такая машина, относительно которой человек, который с ней взаимодействует, не может сказать, с кем он взаимодействует — с человеком или машиной. Это понимание первоначально и прижилось.

С точки зрения Мински, уже давно действуют полноценные системы ИИ. Это общая точка зрения. Именно поэтому ИИ в XX веке в основном был связан с одной задачей — играми. Была цель — создать машину, которая играет лучше, чем человек, и тогда она обладает ИИ. Главный апофеоз пришелся на конец 1990-х — начало 2000-х. Это игра в шахматы и поединок компьютера IВM, который выиграл у Гарри Каспарова* (1997 год). Далее все пытались найти новую игру, в которую бы компьютер побеждал человека. Игра го сложнее шахмат, и в 2016-м искусственный интеллект обыграл в нее человека. Покер сложнее го, и в 2019 году человек уступил компьютеру в эту игру. Потом Watson победил человека в Jeopardy — это аналог нашей «Своей игре». И тогда сказали, что наконец компьютер превзошел человека. Однако затем все-таки решили, что, для того чтобы называться искусственным интеллектом, недостаточно обыгрывать человека в какие бы то ни было игры.

Пожалуй, когда дело касается искусственного интеллекта, все вспоминают знаменитый тест Тьюринга. Его суть в следующем: если при общении с компьютером нельзя понять, с кем идет беседа — с человеком или машиной, то такой компьютер можно считать искусственным интеллектом. Грубо говоря, искусственный интеллект — это интеллект, похожий на человеческий по поведению. Долгое время всех удовлетворяло такое понимание искусственного интеллекта. Собственно, знаменитая экспертная система Watson — это и есть реализация на практике программно-аппаратного комплекса, способного пройти тест Тьюринга. Watson, кстати, породил нынешний бум ботов, которые могут поддерживать элементарную беседу. Существует еще множество определений искусственного интеллекта, но до сих пор единственного признанного всеми нет. Примерно можно определить ИИ как сочетание сверхмощных компьютеров с нейронными сетями и глубоким машинным обучением.

Системы ИИ могут превышать человеческие возможности. Уже сегодня ИИ лучше решает комбинаторные задачи, чем человек. Типичными комбинаторными задачами как раз и являются игры типа шахмат, го и тому подобное. Для многих других задач, относящихся в том числе к творческим или, например, к потенциально опасным, человеческий интеллект не может в ближайшие годы быть заменен искусственным.

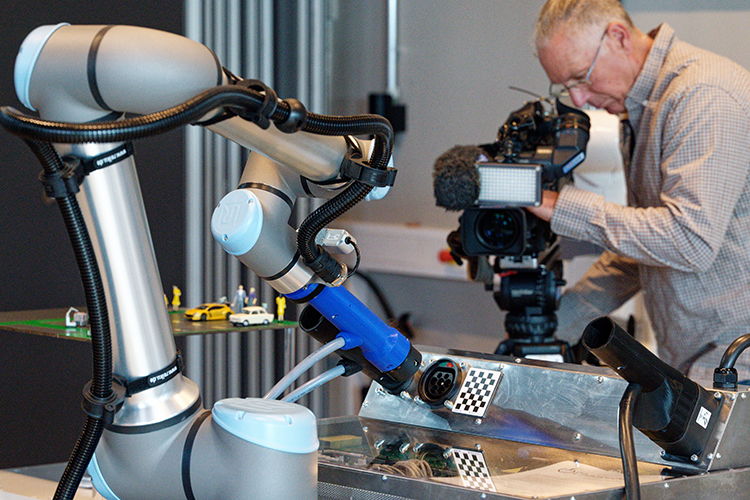

«Системы ИИ могут превышать человеческие возможности. Уже сегодня ИИ лучше решает комбинаторные задачи, чем человек»Фото: Cfoto/Keystone Press Agency / www.globallookpress.com

«Компьютеры пока ближе к арифмометрам и калькуляторам, чем к человеческому мозгу»

— Говорят, что искусственный интеллект — самообучающаяся система и в этом он чем-то похож на человека. Насколько ИИ обучаем, может ли он в этом превзойти человека, дойдя до таких глубин сознания или подсознания, что этот уже высший разум возвысится над нами во всех смыслах? Есть такая вероятность? Платон же описал идеальное государство таким образом, что во главе всего должны стоять бескорыстные высшие существа, у него это философы, а под ними уже могут быть распорядители-чиновники, воины, работники и так далее. Может, это было бы и хорошо? Возможно, этот высший бескорыстный разум без эмоций смог бы дать людям то счастье, равновесие, справедливость, умиротворение и гармонию, которых им так не хватает?

— Одно из направлений развития искусственного интеллекта связывается со способностью программ к самосовершенствованию. Неслучайно, что о нейронных сетях, глубоком обучении и искусственном интеллекте заговорили одновременно. На самом деле известны все они были примерно те же 60 лет. Главная проблема была в дороговизне «железа», то есть самих компьютеров, способных выполнять эти программы. Нейронная сеть может эффективно решать конкретные задачи, но при этом никогда не пройдет тест Тьюринга.

Летом 1956 года в Университете Дартмута в США прошла первая рабочая конференция с участием таких ученых, как Маккарти, Минский, Шеннон, Тьюринг и других, которые впоследствии были названы основателями сферы искусственного разума. В течение 6 недель ученые обсуждали возможности реализации проектов в сфере ИИ. Тогда, кстати, и появился сам термин artificial intelligence (искусственный интеллект). После знаменитой конференции в Дартмуте ИИ получил впечатляющее развитие. Были созданы машины, которые могли решать математические задачи, обыгрывать в шахматы, и даже первый прообраз чат-бота, который мог разговаривать с людьми, вводя их в заблуждение по поводу своей осознанности.

Пожалуй, самое распространенное из этих заблуждений в том, что якобы для создания ИИ надо точно разобраться с тем, как работает человеческий мозг и как он связан с сознанием. Современные специалисты, подчеркиваю, специалисты (!) в области ИИ полагают, что компьютеры пока ближе к арифмометрам и калькуляторам, чем к человеческому мозгу. Они работают на иных принципах, чем наш мозг. Нейронные сети, о которых говорят айтишники, не имеют никакого отношения к нейронам человеческого мозга. Самые совершенные нейронные сети имеют сегодня 5–6 слоев между входом и выходом и минимум синапсов. В человеческом мозге таких слоев сотни тысяч и миллионы. При этом в одних областях компьютеры как программно-аппаратные комплексы уже сегодня превосходят людей, а в других безнадежно уступают. Поэтому человек и компьютер принципиально разные устройства. Так же, как человек не похож на компьютер, так и компьютер не похож на человека.

Грубо говоря, компьютер превосходит человека там, где имеет место огромная комбинаторика, то есть наличие множества вариантов, короткое время исполнения и возможность вести анализ чего-либо путем выполнения последовательных операций, возможность написать алгоритм. Где сегодня мы видим наибольшие прорывы? В анализе больших данных, распознавании образов, поиске незаметных на первый взгляд связей и закономерностей. Отсюда возникает простое заключение. Если бы человек имел бесконечное время на решение той или иной задачи, был дисциплинирован и имел неограниченный объем памяти, то он бы успешно решал все задачи, где компьютер сегодня превзошел человека. Самые знаменитые достижения компьютеров, подаваемых как искусственный интеллект, связаны с победой в играх. Любая игра имеет правила. А там, где есть правила, путь к успеху лежит в комбинаторике и написании алгоритмов. Алгоритмы, или методы искусственного интеллекта, — это «пути» обучения ИИ, которые ему необходимо пройти, чтобы он смог достичь поставленной цели.

Дело в том, что, исходя из определения ИИ, полный цикл обработки информации в настоящее время осуществляется преимущественно на базе комбинаторных методов, глубокого обучения и нейронных сетей. Однако все три метода страдают тем недостатком, что успешно могут работать только с конечными задачами. Наиболее яркий пример конечной задачи — это любая игра, где наперед задано все количество возможных ситуаций и комбинаций, возникающих в ходе игры. Поэтому вероятности возвыситься над человеком у ИИ сегодня попросту нет.

Подытоживая, искусственный интеллект не является чем-то новым и уникальным, тем более пугающим перспективой порабощения человечества феноменом. Сегодня ИИ — это использование старых инструментов и идей в новых продуктах, отвечающих требованиям современного мира. Искусственный интеллект всего лишь помогает человеку решать сложные задачи с множеством переменных и большими массивами данных. А счастье, равновесие, справедливость, умиротворение и гармония — это внутренние характеристики душевного состояния человека, машине неведомые.

— У человека мысли и чувства неразделимы. Восприятие, понимание чего-либо, мечта и воспоминание неизменно вызывают у человека какие-то эмоции — от блаженства до обиды и ярости. Не придет ли вместе с саморазвитием машинного интеллекта машинный набор эмоций, который свойственен, как утверждают ученые, только высшим существам? Если машина станет существом, то, значит, будет испытывать эмоции. Или нет? Какая связь интеллекта и духа?

— А что такое эмоции? Это комплексный психофизиологический ответ организма на события, происходящие в нашей жизни. Чтобы понять, можно ли научить нейросети эмоциям, сначала нужно разобраться с тем, что мы сами понимаем под эмоциями и как их переживаем. С одной стороны, мы полагаем, что эмоциональность — сакральный дар, исключительная привилегия людей. С другой — знаем о ней слишком мало. На сегодняшний день ученые продолжают искать единое решение относительно того, что такое эмоции.

В обывательском представлении искусственный интеллект никогда не сможет приблизиться к человеческой эмоциональности из-за нашей особой душевной организации, которую невозможно трансплантировать в машину. Однако сложности с созданием эмоционального ИИ связаны с тем, что люди не так уж однозначны в эмпатии. Мы совсем не похожи на идеальные эмоциональные машины, которые могут с легкостью расшифровать чувства окружающих. Наша эмпатия серьезно ограничена уникальным опытом, усваиваемыми стереотипами и индивидуальными психоэмоциональными реакциями. Так, европеец вряд ли поймет, какие чувства выражает вождь африканского племени, и наоборот.

На данный момент сложно себе представить калькулятор или арифмометр, обладающий эмоциями. Пока мы можем лишь «проверить гармонию алгеброй», то есть научить ИИ распознавать человеческие эмоции опосредованно через внешние проявления и реакции человеческого тела и демонстрировать сопереживание и эмпатию. Для этого нужно сначала научить нейросеть распознавать эмоции собеседника-человека, чтобы сориентироваться в ситуации. Затем научить ее синтезировать соответствующий ситуации ответ. И наконец научить выдавать этот ответ в форме правильной эмоциональной реакции.

«Поскольку системы ИИ — это системы распознавания, то им свойственны стандартные ошибки, то есть распознавание неверного объекта как искомого и пропуск искомого объекта»Фото: Fang Zhe/XinHua / www.globallookpress.com

«В перспективе развитие ИИ может привести к непредвиденным и потенциально катастрофическим последствиям»

— По поводу ИИ высказывается немало опасений. Говорят, штука очень опасная. Согласно некоммерческой организации Center for AI Safety (CAIS), он может привести к исчезновению человечества. И это не первое предупреждение такого рода. За относительно короткое время несколько авторитетных ученых и предпринимателей заявили о разрушительном потенциале искусственного интеллекта. В чем его опасности — технические, социальные, какие угодно?

— В принципе, ситуация с ИИ не новая. Она возникает каждый раз, когда речь идет о появлении революционной технологии. Она может приносить как огромную пользу, так и гигантский вред. Вопрос в том, сумеет ли человечество правильно и вовремя распорядиться этим достижением науки. Безусловно, искусственный интеллект может быть использован, чтобы привести в действие автономное оружие, продвигать дезинформацию и совершать кибератаки.

80 лет назад великий Айзек Азимов в рассказе «Хоровод» сформулировал три коротких закона робототехники. Робот не может причинить вред человеку или допустить, чтобы человеку был причинен вред. Робот должен повиноваться всем приказам, которые дает человек. Робот должен заботиться о своей безопасности в той мере, в которой это не противоречит первым двум законам. Эти три закона являются этикой роботов и искусственного интеллекта. Однако самонадеянные программисты, разработчики и бизнесмены забыли об Айзеке Азимове. Сегодня не существует этики искусственного интеллекта или роботов. Программы, написанные для экспертных систем или робототехники, не включают встроенные ограничители и не учитывают три закона робототехники Азимова. Важно также учесть, что особенно активно ИИ развивается в оборонной сфере. Риск вовлечения стран в гонку вооружений ИИ может привести к быстрому развитию технологий с потенциально опасными последствиями. Практически каждая программа и приложение, тем более такие сложные, как программы ИИ, содержат много ошибок. Часть из них устраняется в процессе эксплуатации, часть остается необнаруженной в течение всего жизненного цикла программно-аналитического комплекса.

Ошибки при программировании бывают двух типов. Первый порожден некачественным кодом, то есть просчетами и недостаточной квалификацией программистов. Здесь никаких этических проблем и вопросов юридического характера не возникает. Если программист ошибся и его ошибки привели к тяжелым последствиям для отдельных граждан или компаний, то он несет административную, вплоть до уголовной, ответственность. В основе второго типа ошибок лежат неверные алгоритмы. Алгоритмисты и программисты — это разные люди. Программист пишет кодом алгоритм, после чего последний превращается в работающую программу. Главная проблема состоит в том, что алгоритмисты — это в основном математики. Зачастую они испытывают определенные сложности в общении с представителями гуманитарных знаний. Из-за того что алгоритмисты и предметные специалисты зачастую не понимают друг друга, возникают ошибки в алгоритмах.

Вторая группа этических проблем связана с интерпретацией результатов программ человеком или ИИ. Главная проблема в том, что с массовым применением в программировании метода нейронных сетей даже разработчики, не говоря уже о предметниках, перестали понимать, почему программа делает именно такие выводы, а не другие. ИИ может принимать решения, исходя из своей логики, что может быть неэтичным с точки зрения человека.

Автономные системы смертоносного оружия используют искусственный интеллект для идентификации и уничтожения человеческих целей без вмешательства человека. Их летальные версии называют «роботами-убийцами». Автономное оружие, управляемое искусственным интеллектом, а не людьми, будет становиться все более точным, быстрым и смертоносным.

Я привела лишь несколько примеров разрушительного потенциала искусственного интеллекта. В перспективе развитие ИИ может привести к непредвиденным и потенциально катастрофическим последствиям. Опасности искусственного интеллекта всегда должны быть предметом обсуждения, чтобы лидеры могли найти способы использовать эту технологию в благородных целях.

Если сравнивать искусственный интеллект с человеком, то сегодня его развитие находится на уровне ребенка, который только учится держать ложку. Поскольку угрозы напрямую связаны с уровнем развития ИИ, для фактической реализации большинства из них еще очень далеко. Так себе, конечно, утешение.

— В чем разрушительный потенциал, если продолжать развивать эту тему? Мы придумываем для детей всякие ограничения, а ребенок растет, развивается и придумывает, как умно и красиво обойти наши запреты, причем так, что мы не всегда заметим. Нет вероятности чего-то подобного?

— Безусловно, есть технологические риски использования ИИ. Как мы уже выяснили, искусственный интеллект ничего не знает и не умеет думать. Он не знает окружающий мир, слова, явления или еще что-нибудь. Он оперирует всегда с данными, которые преобразованы в числа. Получив множество чисел на входе, ИИ выдает множество чисел на выходе. И он не знает, что за ними стоит. Внутри этого «ящика» могут быть какие-то очень сложные схемы типа нейронных сетей, замысловатые формулы на миллиарды параметров. Но суть от этого не меняется. Это все равно просто некий «ящик».

Ситуация «черного ящика» приводит к тому, что не существует технических средств аудита систем ИИ в настоящее время, что позволяет разработчику или оператору системы при обучении вносить в систему недокументированные функции (например чужеродные объекты, которые система будет пропускать как разрешенные), обнаружить которые в работающей системе нельзя.

Алгоритмы ИИ часто дают непредсказуемые результаты. Предсказуемость является необходимым условием для эффективного управления искусственным интеллектом человеком. Предсказуемость относится к способности человека предвидеть результаты работы ИИ, что позволяет людям обнаруживать и предотвращать ошибки, допущенные ИИ. Чтобы решить проблему недостаточной предсказуемости, исследователи призвали к созданию более объяснимого и предсказуемого ИИ.

Поскольку системы ИИ — это системы распознавания, то им свойственны стандартные ошибки, то есть распознавание неверного объекта как искомого и пропуск искомого объекта. Во многих системах распознавания процент таких ошибок по-прежнему высок. Если система распознавания лиц имеет, казалось бы, высокую точность 99 процентов, то это значит, что в Москве при поиске преступников «ковровым» распознаванием на улицах могут быть распознаны как разыскиваемые 120 тысяч человек.

Ситуация усугубляется тем, что значительное число ИИ-решений базируется на иностранных платформах. А это повышает риск закладок, недокументированных функций и удаленного управления со стороны разработчика платформы. Риск ошибок или выхода автономных систем с ИИ из-под контроля также существует. Есть вероятность, что автономная ИИ-система с автоматическим принятием решений в критически важных, ответственных областях в результате ошибки или недостаточного обучения примет решение, которое нанесет ущерб людям или критической инфраструктуре просто потому, что программных систем, на 100 процентов защищенных от ошибок, не существует.

— Как строить на нем новую экономику, если он такой опасный? Скажем, автономный пылесос с ИИ придет к выводу, что главный источник грязи и пыли в доме — это человек, а значит, нужно устранить причину, а не следствие. То есть убрать человека, а не убирать постоянно создаваемый им беспорядок. И будет абсолютно прав с логической точки зрения. Но это мелкий и частный пример. А как быть с большими экономическими моделями?

— Сначала пару слов о вашем примере. Робот-пылесос никаким образом не сможет убрать человека. Во-первых, он не знает, что так можно. Данные, на которых его обучали, вряд ли содержали подобные примеры. Во-вторых, он не имеет для этого технических приспособлений.

Что касается больших экономических моделей с ИИ, то они уже существуют. Называются они платформами. Первая полноценная платформа — вторичный рынок товаров и услуг eBay — появилась еще в 90-е годы прошлого века. Сегодня на платформенный принцип перешли социальные сети, интернет-магазины, различного рода сервисы и тому подобное. Наиболее часто в качестве примера платформ используются сервисы так называемой совместной рыночной экономики типа «Яндекс.Такси», Amazon и тому подобное.

Платформенная экономика — это экономика, основу которой составляют платформы, то есть онлайн-системы, являющиеся комплексными типовыми решениями в процессе взаимодействия пользователей. Существуют инновационные платформы, которые обеспечивают технологическую среду. Как правило, платформы позволяют пользоваться специфическими решениями, связанными с ними сервисами и так далее.

В России цифровые платформы получили широкое распространение в таких форматах, как платежные системы, платформы в сфере электронной торговли, финансов, образования, туризма. Онлайн-платформы используются во многих областях, таких как реклама, связь, розничная торговля, транспорт и туристические услуги.

В больших экономических моделях также имеются ошибки. Чем масштабнее модель, чем больше платформа, тем больше ошибок программного кода она будет содержать. Ошибки в коде могут быть разными, например, связанные с логикой программы или математическими вычислениями. При наличии ошибок платформа, скорее всего, будет работать некорректно. Принципиального решения этой проблемы пока нет, но есть несколько вариантов. Первый — расширять базу обучения и исправлять ошибки, если только мы знаем, где ИИ ошибется. Второй — заставить два ИИ обучать друга: один распознает ошибки, а другой пытается запутать первого. Правда, практика показала, что обучающийся ИИ начинает лучше распознавать ожидаемые ошибки и хуже неожиданные.

— Кстати говоря, как и в какие отрасли экономики он будет вписываться и уже вписывается?

— Потенциал искусственного интеллекта огромен. Исследователи сообщают, что лидером по количеству проектов с использованием ИИ является финансовая отрасль. Здесь технологии позволяют снизить издержки, минимизировать риски, предотвратить фрод, проверять заемщиков, оценивать их платежеспособность, осуществлять прогнозирование и так далее. Финансовый сектор всегда был в авангарде использования технологии, и еще 15 лет назад банки начали использовать искусственный интеллект для прогнозирования дефолтов с помощью самообучающихся нейронных сетей.

В ретейле основное направление внедрений ИИ связано с обслуживанием клиентов, оптимизацией логистики, инвентаризацией складских запасов, снижением затрат и прогнозированием спроса. Например, компания «М.Видео» внедрила у себя технологии искусственного интеллекта для улучшения клиентского сервиса через онлайн-магазин. Анализируется поведение клиента на сайте, переходы между страницами, просмотры разделов, система готовит персональные товарные рекомендации, которые направляет зарегистрированному пользователю по почте.

В страховании ИИ применяется для управления документооборотом, обработки клиентских данных, селекции рисков, борьбы с мошенничеством, определения персонализированных страховых услуг и распределения страховых выплат. Используется искусственный интеллект и в промышленности. В первую очередь обращает на себя внимание внедрение ИИ на Магнитогорском металлургическом комбинате. Запущенное решение помогает принять решение по диапазону химического состава сырья для стали для оптимизации качества и себестоимости продукции. Далее по подобной модели компания внедрила искусственный интеллект в производство шоколада и экстракцию золота.

Внедрение ИИ в здравоохранение обещает принести пациентам и врачам много преимуществ. Прежде всего сектор здравоохранения в целом был ориентирован на сбор точных и актуальных данных о пациентах и тех, кто обращается за помощью. Это делает искусственный интеллект подходящим для богатого данными мира здравоохранения.

ИИ в логистике может радикально изменить операции. Прогнозная аналитика может точно предсказать запасы, необходимые поставщику, и оптимизировать маршруты для минимизации накладных расходов. Судоходные компании получат большую выгоду от внедрения ИИ. Обычно проверка документов на таможенных постах задерживает процесс доставки. Сегодня судну требуется несколько рабочих дней, чтобы получить разрешение на отправку всех своих товаров. Алгоритмы распознавания изображений и интеллектуальная автоматизация могут помочь сотрудникам таможни более эффективно проводить проверки, сканируя соответствующие документы и переводя их в цифровую среду. Затем эти данные можно использовать для точного отслеживания поставок и сокращения времени, проведенного в портах. Благодаря преимуществам этой технологии мировая судоходная отрасль также внедрила ИИ, особенно прогнозную аналитику, для оптимизации экономики цепочки поставок.

Причина, по которой искусственный интеллект внедряется в таких больших масштабах в различные сферы экономики, связана с его способностью привносить интеллект в задачи, которые раньше не выполнялись.

«В последние годы ИИ имплантируют в различные типы автономных транспортных средств. Например, создаются системы, включающие центральный ИИ и роевые или стайные автономные транспортные средства, оснащенные датчиками и интерфейсами»Фото: Christiane Oelrich/dpa / www.globallookpress.com

«Сама логика развития ИИ ведет к тому, что возможности двойного использования будут постоянно увеличиваться»

— В свое время атом условно разделили на мирный и военный. Но взрыв в Чернобыле показал, что мирного атома в принципе не бывает и авария на АЭС — это взрыв той же атомной бомбы. Потому сейчас так кипят страсти вокруг Запорожской АЭС. ИИ тоже сегодня пытаются условно разделить на мирный и военный. Это возможно или будут прямые аналогии с атомом?

— ИИ — технология двойного назначения. Он может быть использован как для гражданских, так и для военных целей, поскольку некоторые задачи, требующие интеллекта, могут быть и в гражданской, и в военной областях. ИИ обладает свойством двоякого использования так же, как и человеческий интеллект. Скорее всего, сама логика развития ИИ ведет к тому, что возможности двойного использования будут постоянно увеличиваться. Многие задачи, которые в настоящее время автоматизируются, являются по своей сути двойственными. Например, ИИ, анализирующий программное обеспечение на уязвимости, может выполнять как наступательные, так и оборонительные функции. Все то же самое относится к стаям дронов, находящихся под управлением ИИ. Машинное обучение в одном случае будет, например, повышать качество доставки медикаментов в отдаленные районы, а в другом — точность доставки бомб на поле боя.

Системы ИИ обычно эффективны и масштабируемы. Мы говорим, что система ИИ является эффективной, если после обучения может решить определенную задачу быстрее и дешевле человека. Мы говорим, что система ИИ масштабируема, если она может выполнить определенную задачу за счет увеличения вычислительной мощности без качественного изменения программно-аппаратной основы.

ИИ — это технология тройного назначения, которая может быть использована как для гражданских, так и для военных целей. Отдельное направление использования ИИ — мафиозно-террористическое. Но, откровенно говоря, самое активное использование ИИ сейчас наблюдается в военных целях. Изучается множество разнообразных направлений его использования в сфере военного, финансово-экономического и поведенческого противоборства. Бо́льшая их часть засекречена, но есть и публичные. Они связаны с анализом разнородной структурированной и неструктурированной разноформатной, зашумленной и неполной информации. С использованием ИИ, в том числе для прогнозирования будущих событий, таких как террористические атаки, гражданские беспорядки, финансово-экономические, политические и военные кризисы и тому подобное. Также ИИ активно используется для разработки алгоритмов одновременного многоязычного распознавания речи и перевода акустической речи в тексты с уровнем, превосходящим применяющиеся в настоящее время системы машинного перевода.

У ИИ может быть многообещающее будущее в сфере военной логистики. Например, ВВС США используют ИИ для составления графиков обслуживания летательных средств, включая графики дозаправки в воздухе и проведения ремонта. Вместо того чтобы осуществлять дорогостоящий ремонт, когда самолет или вертолет выходит из строя из-за поломок, ИИ разработал модели, позволяющие проводить предупредительное техническое обслуживание воздушных судов.

Активно ИИ используется в киберпространстве. Например, для мгновенного обнаружения аномалий и дыр в киберзащите. Представляется, что именно ИИ с его быстродействием позволит наиболее эффективно управлять боевыми киберплатформами.

Как известно, одной из наиболее сложных в практическом плане задач является сохранение управляемости и поддержание взаимодействия командования и боевых единиц в ходе реальных военных действий. Строго говоря, противник наносит удары не только на поле боя, но и по центрам командования. До настоящего времени ни в одной стране мира, насколько известно, не создана система регенерации командования и контроля в жестких конфликтах. Регенеративная система должна быть организована таким образом, чтобы после выхода из строя тех или иных узлов и уровней командования система перестраивалась и в новой конфигурации сохраняла высокий уровень управления и координации.

В последние годы ИИ имплантируют в различные типы автономных транспортных средств. Например, создаются системы, включающие центральный ИИ и роевые, или стайные, автономные транспортные средства, оснащенные датчиками и интерфейсами. Они, в свою очередь, позволяют перейти от индивидуального к коллективному машинному обучению. Создаются полноценные беспилотные истребители и самолеты-штурмовики, не уступающие, а по ряду параметров превосходящие такие же самолеты, пилотируемые людьми. Испытываются прототипы сухопутных автономных транспортных средств, в том числе оснащенных средствами огневого поражения.

Многие задачи, которые в настоящее время автоматизируются, являются по своей сути двойственными и даже тройственными. Например, ИИ, анализирующий программное обеспечение на уязвимости, может выполнять функции киберзащиты, кибердиверсий и киберпреступлений. Все то же самое относится к стаям дронов, находящихся под управлением искусственного интеллекта.

«Существует концепция развития регулирования отношений в сфере технологий ИИ и робототехники на период до 2024 года»Фото: Friso Gentsch/dpa / www.globallookpress.com

«Искусственный интеллект в ближайшие годы вызовет жгучий интерес у криминала»

— Вы как-то говорили, что любую новую технологию можно условно разделить на гражданскую, военную и криминальную. Какова опасность криминального использования ИИ и новых цифровых технологий? Есть вероятность того, что какой-нибудь чокнутый профессор типа Шурика, сделавшего дома машину времени и убиравшего любые стенки, или условный инженер Гарин захотят создать некий цифровой гиперболоид и получить с его помощью власть над миром или нечто в этом роде?

— Угрозы могут исходить как от самого искусственного интеллекта, так и от злоумышленников, в руки которых он может попасть. Существует две причины, по которым искусственный интеллект в ближайшие годы вызовет жгучий интерес у криминала. Первая — уровень оснащенности программно-аппаратными комплексами самого различного типа квартир, корпораций и государственного сектора является беспрецедентным. Вторая причина притягательности ИИ для криминального сообщества — это незащищенность киберпространства. Если страна может положить конец нелегальной миграции, то в киберпространстве, увы, стену не построишь.

Между тем динамика такова, что из года в год доля компьютерных преступлений, а точнее, преступлений, осуществленных в киберпространстве, в общем объеме преступности неуклонно растет. Преступность необратимо уходит в киберпространство. При этом необязательно, чтобы само преступление совершалось в «виртуале». С появлением «интернета всего» киберпространство все чаще используется для совершения традиционных преступлений при помощи нетрадиционных орудий и методов. Чаще всего ИИ применяется для имплантации вредоносного софта в платежные системы, в основном использующие протокол блокчейн и имеющие Р2Р-архитектуру. Программы искусственного интеллекта в данном случае крайне важны. Они позволяют использовать методы глубокого обучения нейронных сетей для взлома и перепрограммирования платежных протоколов, построенных на блокчейне. Исследования показывают, что программы ИИ справляются с этой задачей эффективнее, чем люди-программисты.

В настоящее время в крупнейших финансовых институтах торговые операции осуществляются роботизированными платформами, базирующимися на последних достижениях ИИ. Высокотехнологичный киберкриминал извлекает прибыль из торговых операций крупнейших финансовых институтов. Это наиболее прибыльная, хотя и достаточно рискованная сфера организованной киберпреступности. В этой связи использование преступными группами искусственного интеллекта для операций на финансовых рынках путем проникновения и компрометации торговых платформ является для них лучшим решением.

Еще одна из сфер использования ИИ многократно описана в фантастических романах и рассказах. Идея использовать робота как орудие убийства совершенно тривиальная. Первым человеком, погибшим от робота, стал американский рабочий Роберт Уильямс в 1970-е годы. Он работал на автоматизированном предприятии, выполнявшем покрасочные работы для автомобильной индустрии. В результате нарушения программы, отвечающей за координацию автоматических манипуляторов одного из роботов, последний вместо дверцы схватил за шею рабочего и удушил его. Вполне вероятно, например, появление подпольного синдиката, специализирующегося на заказных высокотехнологичных убийствах, замаскированных под технические инциденты различного рода. Главным инструментом подобных синдикатов должны быть не хакерские программы сами по себе, а искусственный интеллект. Только ИИ под силу замаскировать злонамеренное отключение или выполнение несанкционированных действий техническим отказом.

— Как такому противостоять? Кто будет это делать? Касперский один явно не справится. Может, нужна будет какая-то цифровая полиция?

— Как противостоять криминалу с искусственным интеллектом? Использовать новые информационные технологии, все тот же искусственный интеллект. Его применение позволит перейти от аналитической к прогностической работе, где главным продуктом является не анализ того, что произошло, а прогноз на будущее. Именно с прогнозированием на основе современных информационных технологий и прежде всего искусственного интеллекта полиция связывает свои надежды. ИИ наиболее эффективно может быть использован для прогнозирования криминальных актов, моделирования поведения преступников и распознавания признаков подготовки к преступлениям, для создания моделей индикаторов, свидетельствующих о степени уязвимости того или иного субъекта или объекта к преступным действиям, а также его привлекательности для криминала.

Что касается практического использования полицейскими ИИ в повседневной деятельности, то известно несколько программно-аппаратных комплексов, задействованных в подобной работе. Самый известный — американский Palantir. Уже сейчас ни одно преступление не совершается без использования информационно-коммуникационных технологий. Поэтому каждый современный полицейский должен обладать необходимыми знаниями по борьбе с высокотехнологичной преступностью.

— Сейчас ИИ пытаются активно применять в борьбе с коррупцией, что для нашей страны более чем актуально. Так, например, система OCEANO анализировала данные с помощью ИИ, технологии которого помогают в борьбе с коррупцией по всему миру. В Бразилии в 2017 году появился проект Operação Serenata do Amor с алгоритмом Rosie, изучающим парламентские расходы депутатов и сенаторов. А один из крупнейших мировых пивоваров — компания AB InBev — на специальной платформе Operation BrewRIGHT, отслеживая потоки своей информации методом машинного обучения, вычисляет незаконные платежи и недобросовестных деловых партнеров. Как вы оцениваете этот опыт? Каково его будущее у нас? Может быть, для нас методы ИИ в противодействии коррупции не просто важны, а единственно возможны, как вы считаете?

— Коррупция представляет угрозу национальной безопасности и наносит значительный ущерб социально-экономическому развитию страны. Она носит массовый характер, затрагивает все сферы человеческой деятельности. Противодействие коррупции является одной из приоритетных задач государственной политики. Многие страны мира занимаются развитием ИИ, чтобы в будущем можно было использовать новые эффективные методы в борьбе с коррупцией, которые заменят прежние методы, потерявшие свою эффективность. Мы, бесспорно, должны развивать новые технологии в области ИИ и адаптировать его к борьбе с коррупцией, которую хоть и невозможно искоренить навсегда, но можно снизить уровень коррупционных преступлений. И обязательно нужно использовать положительный опыт других стран, уже применяющихх ИИ в борьбе с коррупцией. Однако, как сообщают СМИ, в прошлом году был подписан указ президента Владимира Путина об антикоррупционной системе «Посейдон». В документе сказано, что государственная информационная система в области противодействия коррупции «Посейдон» создана для повышения эффективности деятельности по профилактике коррупционных и иных правонарушений. «Посейдон» будет иметь доступ к самой разной информации: официальным базам, социальным сетям, внутренним документам. Искусственный интеллект должен искать все пересечения и совпадения, анализируя сведения из реестров собственности, изучая фотографии в соцсетях, родственные связи. Система смотрит, где и сколько денег потратил чиновник. Так можно выявить нестыковки в доходах и расходах. Опять же, по сообщениям СМИ, похожая программа уже работает в «Росатоме».

— В США создан и работает центр безопасности ИИ. Китай активно разрабатывает уже второй пакет законодательства, регулирующего ИИ в стране. У нас делается нечто подобное?

— Сейчас в России нет законодательной базы, регулирующей отношения в области ИИ. Даже понятие «искусственный интеллект» на законодательном уровне в Российской Федерации не дается. Что, впрочем, не мешает его использовать. Правительство РФ планирует утвердить правила использования искусственного интеллекта. С 2020 года в Москве проходит эксперимент по установлению правового регулирования создания условий для разработки и внедрения технологий ИИ. С 2021-го 160 организаций из разных регионов присоединились к кодексу этики в этой сфере. Кроме того, существует концепция развития регулирования отношений в сфере технологий ИИ и робототехники на период до 2024 года. В ней затрагиваются вопросы регулирования оборота данных, юридической ответственности в случае применения ИИ, информационная безопасность, а также возможность применения таких технологий в разных сферах экономики. Так что законодательство пока ждем.

«Нейросеть — это компьютерная программа, способная к обучению. Одним из самых интересных примеров нейронной сети является ChatGPT — система, разработанная OpenAI, которая способна генерировать текст на основе заданной подсказки»Фото: Philipp von Ditfurth/dpa / www.globallookpress.com

«Даже разработчики перестали понимать, почему программа делает именно такие выводы, а не иные»

— Давайте более подробно поговорим о нейросетях. Достаточно вспомнить совсем недавний случай, когда студент из Москвы обманул преподавателей и защитил диплом, написанный нейросетью ChatGPT. Что это такое? Каково их будущее? У нас над ними идет работа? Каковы ее успехи?

— Нейросеть — это компьютерная программа, способная к обучению. Перед ней можно поставить практически любую задачу. И если сначала показать машине тысячу-другую верных решений, то затем она научится находить правильный ответ самостоятельно. За нейронными сетями стоит сложная математика. При этом модель компьютерной сети построена по принципу работы нервных клеток человека, то есть биологических нейронных сетей. Это ресурсоемкая задача как по вычислительной мощности, так и в плане подготовки огромного объема необходимых данных. Главная проблема в том, что с массовым применением в программировании метода нейронных сетей даже разработчики перестали понимать, почему программа делает именно такие выводы, а не иные.

Для того чтобы объяснить коллизию, придется в нескольких словах охарактеризовать отличие нейронных сетей от обычной программы. Последняя может быть записана на бумаге как последовательность операций. Мы всегда знаем причинно-следственную связь. Нейронная сеть — это самосовершенствующаяся программа. В ней задается исходно только архитектура и правила изменения удельных весов при принятии решения. Все остальное делает алгоритм. Грубо говоря, нейронные сети — это те самые пресловутые «черные ящики». Известна только информация на входе и на выходе.

Одним из самых интересных примеров нейронной сети является ChatGPT — система, разработанная OpenAI, которая способна генерировать текст на основе заданной подсказки. ChatGPT был обучен на наборе данных из более чем 8 миллиардов слов, включая широкий спектр текстов из книг, статей и веб-сайтов. Это позволяет ему понимать структуру и стиль человеческого языка и генерировать естественные и связные ответы. Уникальной особенностью ChatGPT является возможность продолжить разговор на основе предыдущих обменов. Это означает, что он может «запоминать» то, что было сказано ранее, и основываться на этом, создавая более плавный и реалистичный разговор. Хотя ChatGPT по-прежнему остается машиной и не может по-настоящему понимать слова или испытывать эмоции, он способен имитировать человеческий разговор таким образом, что часто получается убедительно и увлекательно.

Подобные модели обладают огромным потенциалом. Машинное обучение, от которого раньше ожидали решения только рутинных задач, доказало свою способность к сложной творческой работе. Нейросети регулярно совершенствуются, и появляются новые версии, а технологические усовершенствования происходят все быстрее и быстрее. Это открывает широкие возможности для решения многих социальных задач, но одновременно это также может содержать большое количество криминальных рисков, поскольку преступники сразу стали использовать их в своих целях.

Например, ChatGPT можно использовать для изучения огромного количества потенциальных областей преступлений без предварительных знаний, начиная от способов проникновения в дом, заканчивая терроризмом, киберпреступностью и сексуальным насилием над детьми. Способность ChatGPT составлять высокоаутентичные тексты на основе подсказок пользователя делает его очень полезным инструментом для фишинга. Если раньше многие элементарные фишинговые аферы было легче распознать из-за очевидных грамматических и орфографических ошибок, то теперь можно выдать себя за организацию или частное лицо в весьма реалистичной манере даже при базовом знании английского языка, на котором обучена модель. ChatGPT может предложить преступникам новые возможности для преступлений, связанных с социальной инженерией, особенно учитывая ее способность отвечать на сообщения в контексте и принимать специфический стиль письма. Кроме того, различные виды онлайн-мошенничества можно сделать более «легитимными», используя ChatGPT для создания поддельных социальных сетей, например для продвижения мошеннического инвестиционного предложения.

ChatGPT превосходно справляется с созданием аутентичного звучащего текста на скорости и в масштабе. Это делает модель идеальной для целей пропаганды и дезинформации. Она позволяет пользователям генерировать и распространять сообщения, отражающие определенный нарратив, с относительно небольшими усилиями. Например, ChatGPT может использоваться для создания онлайн-пропаганды от имени других субъектов для продвижения или защиты определенных взглядов, которые были развенчаны как дезинформация или фальшивые новости.

У нас тоже есть подобные системы. Например, GigаСhat от Сбера, FractalGPT от компании «Аватар Машина», SistemmaGPT от компании Sistemma. В 2023 году «Яндекс» заявил, что разрабатывает новую нейросеть YaLM 2.0.

— И последний вопрос. Человекообразные роботы с ИИ. Вспомним известный фильм «Искусственный разум» 2001 года. Ведь мы уже идем по этому пути. Достаточно сказать, что гиноид (человекоподобный робот в виде женщины) София в 2017-м стала подданной Саудовской Аравии и первым роботом, получившим гражданство какой-либо страны. Не получится ли так, что через какие-нибудь 8–10 лет мужчины перестанут жениться на живых женщинах, которые «выносят мозг», а женщины выходить замуж за мужчин, которые «валяются на диване и дуют пиво», а предпочтут искусственный разум, запрограммированный под безграничную любовь к ним и удовлетворение их потребностей и фантазий? И дети будут искусственные, вечно маленькие и вечно милые. Что нас тогда ждет — вырождение?

— Я отлично помню историю с Софией. Она получила гражданство Саудовской Аравии. Но с тех пор больше ни один робот не получил гражданства какой-либо страны. Да и София не получила гражданства других государств. Почему?

Крупнейшие публичные компании активно вкладываются в сервисы на основе технологии ИИ. Для частного инвестора, следящего за технологическими трендами, это хорошая возможность заработать. Искусственный интеллект, без сомнения, одна из самых модных тем современности. Об этой технологии говорят и ее внедряют во все сферы жизни — от транспорта и промышленности до образования и культуры. Применение ИИ, в отличие от многих других технологий, практически не ограничено — ведь автоматизация возможна почти во всем.

Разговоры о беспилотных автомобилях уже стали привычными — над автоматизацией работают все крупные автопроизводители. Появление полностью беспилотных такси, которые, например, смогут захватить вас по пути с работы, лишь вопрос времени. Умные дома уже в значительной степени стали реальностью. И тогда София от Hanson Robotics становится первым в мире роботом, получившим гражданство в рамках программы, согласно которой Саудовская Аравия станет центром инвестиций по поддержке компаний информационных технологий. Это событие спровоцировало споры, так как некоторые комментаторы начали задаваться вопросами, подразумевало ли это, что София может голосовать или вступать в брак и можно ли считать преднамеренное отключение робота убийством. Пользователи социальных сетей использовали данное событие для того, чтобы критиковать ситуацию с правами человека в Саудовской Аравии. Событие вызвало скандал в Саудовской Аравии, так как во время конференции и объявления о гражданстве София находилась с непокрытой головой и лицом, без хиджаба и без мужчины-опекуна. Скандал имел в том числе и финансовый эффект. Благодаря ему многие компании, занимающиеся разработками в области ИИ, успешно привлекли инвестиции для своих проектов. Спасибо Софии.

Кстати, уже выпущено 13 копий Софии, потому что ее лицо сделано из материала, который быстро изнашивается. В этой связи я уверена, что вырождение нам пока не грозит.

* выполняет функции иностранного агента

Автор: Вадим Бондарь

Заглавное фото: Kremlin Pool / Global Look Press